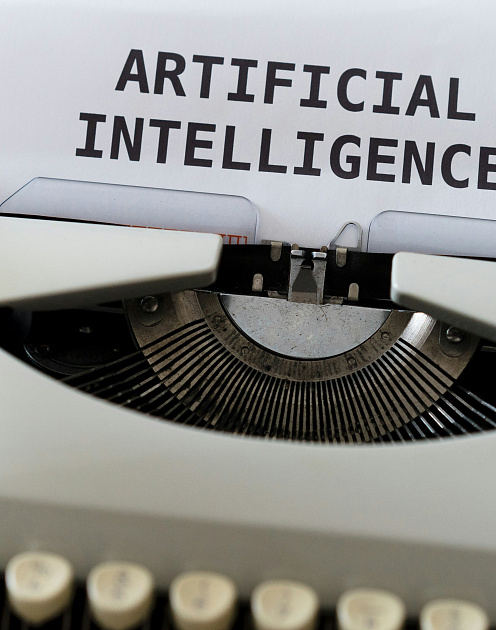

В последние месяцы все больше ведущих специалистов по работе с ИИ покидают крупнейшие компании — OpenAI, Google DeepMind и другие — на фоне разворачивающейся дискуссии об угрозах искусственного интеллекта для человечества. Среди них — Илья Суцкевер, сооснователь OpenAI, Ян Лейке, руководитель отдела разработки ИИ OpenAI, Мира Мурати, технический директор OpenAI, и другие.

Все громче звучат опасения по поводу безопасности ИИ и высокой вероятности так называемого p(doom) — это термин в безопасности ИИ, который обозначает возможность экзистенциально катастрофического исхода (или гибели) человечества в результате деятельности искусственного интеллекта.

Основатель SpaceX, инвестор и генеральный директор Tesla, соучредитель Neuralink и OpenAI Илон Маск оценивает риски негативного сценария развития ИИ в 20%. Его поддерживает британо-канадский ученый и лауреат Нобелевской премии по физике Джеффри Хинтон — несмотря на то, что именно его разработка позволила нейросетям самообучаться при минимальном вмешательстве человека, в 2023 году он ушел из Google из-за неуверенности в безопасности буквально созданной им технологии. Хинтон считает, что ИИ угрожает вымиранию человечества в ближайшие 30 лет с вероятностью от 10 до 20%.

Оценка развития сценария p(doom), безусловно, очень примерная, ведь мы как цивилизация еще не сталкивались с тем, что демонстрирует когнитивные способности на уровне с нами или превосходит человеческие.

При этом совершенно точно можно утверждать, что в развитии ИИ существуют опасности.

Я бы хотел разделить их на три части:

использование ИИ людьми для личной выгоды;

бесконтрольность новых технологий, а именно действие ИИ в качестве самостоятельного актора;

несоответствие скорости совершенствования технологий общественному развитию, когда первое значительно опережает темпы изменения социальных институтов, общества и самого человека.

Если ИИ будет работать на частные интересы во вред другим

Когда ИИ используется людьми для решения полезных задач — от медицины до логистики — мы можем увидеть конкретный положительный эффект от этого. Но, как и во время предыдущих технологических революций, инновации нередко начинают использоваться людьми в негативных для общества целях.

Яркий пример — дипфейки. Более 89% ложных изображений и аудио связаны с политикой, силовыми структурами и государственной безопасностью, утверждает Международная ассоциация по фактчекингу GFCN. Манипулирование общественным мнением в этих областях может повлиять не только на эмоциональный фон одного человека, но и угрожать социальной стабильности в целом. Дипфейки слишком похожи на оригинал, поэтому люди верят им и могут принять необдуманные решения под их влиянием.

Но иногда негативное влияние ИИ проявляется ненамеренно: когда хочешь сделать лучше, но не можешь учесть все риски — и получается намного хуже. Например, использование публичных нейросетей (ChatGPT, DeepSeek и т.д.) не только в личных, но и в рабочих целях приводит к распространению конфиденциальных данных. Татьяна Фомина, директор по информационным технологиям и кибербезопасности HeadHunter, говорит о том, что если не получается что-то запретить, нужно это возглавить. Она предлагает обеспечить безопасные условия для использования новых технологий в компаниях — например, развернуть проприетарные аналоги публичных LLM в контуре компании. А передача данных таких LLM будет ограничена системой безопасности организации. Это поможет контролировать использование нейросети для рабочих целей и исключить возможность утечки внутренней информации.

При этом мы можем увидеть примеры того, как ИИ работает на благо общества. Например, новые технологии могут стать сильным преимуществом в сферах, где для достижения результата необходимо провести большую аналитическую работу и сопоставить факты. Так, по экспертным оценкам, с помощью ИИ было раскрыто до 70% всех зарегистрированных преступлений в общественных местах Москвы.

Если ИИ научится принимать решения самостоятельно

В этом случае мы говорим о том, что ИИ обладает собственной субъектностью и может определять свои действия в изменяющихся обстоятельствах. На момент подготовки материала — июль 2025 года — ни один ИИ-агент не достиг человеческого уровня осознанности, саморефлексии и автономии.

Но технологии в своем развитии целенаправленно идут в эту сторону. Уже существуют продвинутые ИИ-агенты, которые могут самостоятельно действовать в узких симулированных средах. Например, они могут проходить сложные компьютерные игры (StarCraft II, Dota 2) на уровне человека или даже лучше него. Главная особенность — умение адаптироваться к контексту и реагировать на неожиданные сценарии. Но при этом все цели строго ограничены уровнем или игровой задачей, вне игры такие агенты не могут проявить свои стратегические навыки.

Сегодня мы можем говорить только о симуляции человеческого мышления со стороны ИИ. Технология пока недостаточно обучена, чтобы уметь выстраивать цепочки рассуждений и принимать обоснованные решения.

Если ИИ перекроит мир быстрее, чем общество сможет на это отреагировать

И третий сценарий говорит о том, что темпы развития ИИ превышают скорость изменения общественных институтов (школ, университетов и других) в ответ на новую реальность. Так, лишь часть человечества, узурпируя новое средство производства, как сказал бы Маркс, сможет обеспечивать эффективный результат своей деятельности, которого у других достичь не получится.

В Кремниевой долине уже запустили новый тренд в духе меняющейся реальности — теперь эффективность команд оценивают по величине дохода на одного сотрудника. Средний доход на человека в топ-10 AI-стартапах уже достиг $3,48 млн, что значительно выше, чем у ведущих SaaS-компаний. Если эта тенденция будет распространяться и дальше, то даже несколько человек в команде, умеющие эффективно использовать нейросети, смогут решать значительно больше задач. Это означает, что работодатели могут позволить себе сократить часть персонала.

И не только его! 63% руководителей утверждают, что ИИ приводит к увеличению доходов, а 44% сообщают о снижении расходов, свидетельствует опрос McKinsey.

Благодаря новым технологиям стартапы достигают миллиардных показателей с командами, в составе которых работают менее 10 человек (к примеру, Cognition AI), а средний размер команды у лидеров рынка — всего 24 сотрудника.

Более того, распространение ИИ меняет и лидерскую роль: по данным исследования PwC, 85% CEOs полагают, что ИИ радикально изменит их бизнес в течение пяти лет, а 65% компаний уже используют новые технологии для принятия стратегических решений. Например, ИИ ускоряет запуск новых продуктов: в Nestlé время вывода новинок на рынок сократилось на 60%.

Эти изменения формируют новую философию бизнеса — гибкость, скорость и максимальная отдача от каждого члена команды становятся главным конкурентным преимуществом.

Что в итоге?

ИИ настойчиво проникает в нашу реальность, оптимизируя процессы и открывая новые возможности перед бизнесом в частности и человечеством в целом. Так как ИИ-агенты все еще не самостоятельны и не могут принимать решения, то угроза может исходить от тех, кто ими управляет.

При этом важно помнить, что те, в чьих руках находится технология, не всегда готовы использовать ее исключительно во благо. Поэтому сейчас более вероятным кажется сценарий, в котором вред человечеству могут нанести сами люди, если ИИ станет игрушкой в их руках в обычной жизни и преимуществом на политической арене.

Но еще есть шанс, что ИИ останется технологией открытой. Сам факт доступности не позволит никому узурпировать ее преимущества, но даст возможность использовать их, если это необходимо. Как замечательно сказал CEO & Founder AI Talent Hub — крупнейшей ИИ-магистратуры в России — Дмитрий Ботов: «Если к технологии имеют доступ все, она не сможет стать оружием в чьих-то одних руках».