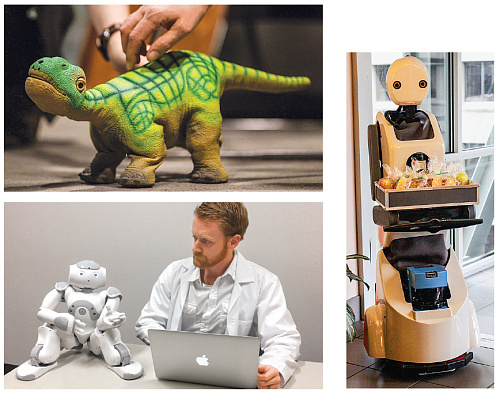

На конференции «2013 Robotic» научный сотрудник MIT Кейт Дарлинг предложила посетителям поиграть с аниматронными игрушечными динозавриками Плео и придумать им имена. Оказалось, что с Плео очень даже можно общаться: динозаврики жестами и мимикой показывали, что им нравится, когда их гладят, и не нравится, когда их таскают за хвост. Через час Кейт объявила перерыв. Когда «игроки» вернулись, она раздала им ножи и топорики — чтобы поистязать своих динозавриков и разрубить их на куски. Кейт предполагала, что эта идея не вызовет восторга, но, что ее поразило, люди все как один наотрез отказались причинять роботам вред. Кто-то даже заслонил собой динозавриков, защищая их. В докладе на конференции Кейт подвела итог эксперименту: «Эти машины общаются с нами “по-человечески”, и мы воспринимаем их как живых, даже если понимаем, что это не так». Этот вывод будет главным для следующей волны автоматизации. Как писали в своей книге «The Second Machine Age» Эрик Бриньольфссон и Эндрю Макафи, думающие машины — от автономных роботов, которые быстро осваивают новые задачи в заводских цехах, до программ, способных оценить претендентов на те или иные должности или рекомендовать корпоративную стратегию, — заменяя людей, могут создавать колоссальную стоимость для бизнеса и общества (см. интервью с Бриньольфссоном и Макафи в этом номере). Но хотя технологические ограничения исчезают, социальные остаются. Как убедить подчиненных, что искусственному интеллекту можно доверять? Как относиться к роботу в качестве коллеги, а то и начальника? А если вы замените его, как это скажется на общем настроении группы? Чтобы ответить на эти вопросы, надо представлять себе, как люди будут работать и взаимодействовать с думающими машинами. Благодаря исследованиям, которых становится все больше, мы более или менее понимаем, как налаживать сотрудничество машин и людей. Машины эволюционируют, перестают быть просто инструментами, превращаются в членов коллектива, и становится ясно: работать с ними — совсем не то, что просто освоить новую технологию.

Когда мы не доверяем — или доверяем — алгоритмам

При работе с думающими машинами прежде всего важно помнить, что обычно они знают больше нас. В 2014 году исследователи из Уортонской школы бизнеса провели несколько экспериментов: добровольцам платили деньги, если они делали точные прогнозы — с помощью алгоритмов либо целиком полагаясь на себя. Например, участникам одного эксперимента показали сведения о студентах, которые те предоставляли при поступлении на курс МВА, и просили оценить, как каждый из них учился. Оказалось, что большинство не воспользовалось алгоритмами, а слушало свою интуицию. Этот феномен — его называют избеганием алгоритмов — зафиксирован в ходе многих исследований. Не важно, о чем идет речь — о медицинском диагнозе или политическом прогнозе, — люди больше доверяют не алгоритмам, а «человеческому» мнению, своему или чужому, и потому часто принимают не лучшие решения. Отсюда следует важный для управленцев вывод: их главной задачей будет научить подчиненных доверять думающим машинам. Но недостаточно просто доказать людям надежность алгоритмов. Когда исследователи из Уортона показывали добровольцам их оценки, алгоритмические выводы и правильные ответы, те признавали, что алгоритмы давали более точные результаты. Но они видели и ошибки алгоритмов. «Люди разочаровывались в алгоритмах, обнаруживая, что они ошибаются, — вспоминает Беркли Диетворст, один из исследователей, — они ошибались чаще алгоритмов, но себе доверять не переставали». То есть за ошибки мы судим алгоритмы строже, чем себя. Диетворст объясняет это так: мы уверены, что человек может изменить свою точку зрения, а вывод алгоритма изменить нельзя (хотя это неверно). В работе, которая нам кажется более сложной (или требующей особо тонкой интуиции), чем просто «перемалывание чисел», феномен избегания алгоритмов проявляется еще очевиднее. Исследователи из двух бизнес-школ — Келлога и Гарвардской предложили завсегдатаям краудсорсинговой платформы Mechanical Turk несколько заданий. Одним сказали, что их выполнение требует способности осваивать новое и «аналитического мышления», а другим, что главное — «ощущения» и «понимание эмоций». Затем добровольцев спросили, были бы они довольны, если бы подобную работу передали машинам. Предупрежденных об эмоциональном характере работы идея насчет машин задела больше, чем тех, кому ее представили как сугубо аналитическую. «Люди думают так: мыслить — это почти то же самое, что делать расчеты, — предполагает один из авторов исследования Майкл Нортон, сотрудник Гарвардской школы бизнеса. — Для роботов считать — нормально. Но для них совсем не нормально испытывать чувства, потому что это делает их слишком похожими на людей». По мнению Нортона, недоверие к алгоритмам преодолеть просто — надо лишь назвать задачу аналитической. В ходе еще одного эксперимента, который он проводил с Адамом Уэйцем из бизнес-школы Келлога, выяснилась забавная вещь. Люди охотнее признают, что робот может преподавать математику, если им объясняют: «обучение студентов формулам и алгоритмам требует недюжинных аналитических способностей». Те, кому говорят, что преподаватель математики должен «уметь общаться с молодежью», не готовы видеть робота в роли учителя. Диетворст и его коллеги из Уортона предлагали другое объяснение. Если люди свои выводы ценят больше алгоритмических расчетов, то почему бы не объединить первое и второе? Почему бы не дать им возможность чуть изменить вывод алгоритма? Ученые предложили добровольцам определить на основании разнообразной информации, хорошо ли ученик старших классов выполнит стандартную контрольную по математике. Участникам эксперимента не надо было выбирать между двумя оценками — своей и алгоритма; можно было поправить результат алгоритма, прибавив или отняв несколько процентов, и представить итог как собственный вывод. И добровольцы отнеслись к алгоритму более благосклонно. Потому, считает Диетворст, что в таком случае у людей появляется ощущение, будто они самостоятельно делают вывод.

Плео — лишь один пример «робототехники для общения». Он общается с помощью жестов и мимики. Ему, например, нравится, когда его гладят, и не нравится, когда его поднимают за хвост. Snackbot развозит по офису закуски, разговаривает с сотрудниками и может запомнить, какие закуски кто предпочитает. У Джима есть голос, и он может жестикулировать, поэтому его воспринимают как разумное существо, хотя на самом деле им управляют исследователи.

Мы больше доверяем роботам, если они внешне похожи на нас

Еще один способ вызвать у людей доверие к думающим машинам — сделать их человекоподобными. Исследования показывают, что если наделить алгоритм голосом и дать машине человекоподобное тело, то люди относятся к ним благожелательнее. Ученые из нескольких университетов изучали эту реакцию на примере самоуправляемых автомобилей. В ходе эксперимента добровольцы пользовались автомобильным тренажером и могли либо сами рулить, либо выбрать беспилотный режим. Автопилот в одних случаях только контролировал направление движения и скорость, в других — обладал некоторыми человеческими чертами: у него было имя (Айрис), женский голос, он умел разговаривать. Если на тренажере был установлен автопилот Айрис, то водители охотнее выбирали беспилотный режим. Кроме того, исследователи запрограммировали ДТП, оно происходило по вине не автопилота, а другого автомобиля. Водители машин, управляемых Айрис, меньше нервничали и реже обвиняли автопилот в том, что из-за него случилось ДТП, чем те, у которых автопилот был без имени и голоса. По мнению исследователей, Айрис люди доверяли больше из-за склонности наделять человеческими свойствами, например способностью думать и чувствовать, все, что не принадлежит к человеческому роду. Исследования показывают, что людям спокойнее работать с человекоподобными машинами. В частности, проще сотрудничать с роботами, когда они встречаются с нами «взглядом». А если они умеют склонять голову набок, то нам кажутся более симпатичными и похожими на людей — помните Плео? Эту идею изучали исследователи из Университета Карнеги — Меллона. У них был робот Snackbot, высотой 1,5 м, с колесами, руками и светодиодным ртом. Он мог говорить мужским голосом, улыбаться и хмуриться. Snackbot развозил по офису закуски, но на самом деле его задумали, чтобы он пробуждал в людях ту самую склонность к очеловечиванию. Как и предполагали исследователи, люди разговаривали с ним и относились к нему добродушно. Кто-то сказал: «Snackbot не испытывает чувств, но я не могу просто взять еду и закрыть перед ним дверь». Робота запрограммировали на «индивидуальные» беседы с отдельными сотрудниками, например на обсуждение их любимых закусок. Людям, к которым Snackbot проявлял внимание, он особенно нравился, и они охотнее откликались, когда он обращался к ним.

Но иногда роботы слишком человекоподобны

Придание думающим машинам человеческих черт может и сбивать с толку. В частности, люди начинают слишком уж верить в их способности. Исследователи из Университета Манитобы провели эксперименты, в ходе которых участники должны были делать монотонную работу: переименовывать файлы в компьютере. Им не сказали, сколько времени будет длиться эксперимент (предупредили лишь, что в любой момент можно встать и уйти), но количество еще не переименованных файлов казалось бесконечным. Когда наконец кому-нибудь из добровольцев работа надоедала, их тут их осаждал Джим, 60-сантиметровый человекообразный робот. Джим сидел на столе, говорил механическим голосом, придирчиво оглядывал комнату и жестикулировал. Эти свойства свидетельствовали о его интеллекте (добровольцы не знали, что роботом управляли исследователи). Если кто-нибудь порывался уйти, Джим говорил: «Пожалуйста, не останавливайтесь» или «Обязательно продолжайте». Так он делал до тех пор, пока участники эксперимента не переставали обращать на него внимание и не бросали работу, либо до тех пор, пока не истекали полтора часа. Джеймса Янга, одного из авторов исследования, больше всего поразило, что многие «отнеслись к роботу как к существу, с которым можно вести переговоры». Эти люди, по-видимому, уверовали в способность робота мыслить лишь потому, что он был говорящим и человекообразным. Другая проблема в том, что чем больше машины похожи на людей, тем охотнее люди относятся к ним как к себе подобным. Исследователи из Университета Сунгсил (Южная Корея) оценивали, насколько люди довольны роботом-охранником, который анализировал видеозаписи с камер наблюдения. Сначала робота звали Джоан и он разговаривал женским голосом, потом он получил имя Джон и мужской голос, и в этом виде виде его сочли более полезным, хотя Джон и Джоан выполняли одну и ту же работу. А исследования, в которых фигурировали роботы, выполнявшие работу по дому, фиксировали обратный эффект. Наконец, человекоподобные роботы могут провоцировать конфликты на работе. Во время эксперимента робот Snackbot, обращаясь к одному из своих клиентов, громко говорил о том, как тот часто заказывает арахисовую пасту, и человеку было неловко, что все вокруг слышат это. Еще один участник эксперимента почувствовал себя уязвленным, когда Snackbot сделал комплимент его коллеге: тот трудится не покладая рук. «Чем больше вы очеловечиваете робота и особенно чем больше он проявляет “эмоций”, тем чаще он вызывает у людей такого рода чувства, — говорит Джонатан Грэтч, профессор Университета Южной Калифорнии, который изучает общение человека с машиной. — Не сказать, что от коллеги-робота ждут, чтобы он был точь-в-точь как человек. Хочется, чтобы он был лучше человека». Грэтч проводил и собственное исследование; его интересовало, как сделать, чтобы думающие машины вызывали у людей доверие, и в то же время обойти некоторые ловушки антропоморфизма. Во время эксперимента две группы обсуждали свое здоровье с виртуальным человеком (персонажем, созданным с помощью цифровой анимации), который появлялся перед ними на телеэкране. Одной группе сказали, что персонажем управляют люди, другой — что он полностью автоматизирован. Добровольцы из второй группы больше рассказывали о своем здоровье и даже больше жаловались на жизнь. «Если с нами говорит человек, мы опасаемся, как бы о нас не подумали плохо», — говорит Грэтч. Грэтч предполагает, что «иногда машине лучше не быть похожей на человека». Например, «если бы вашим начальником был компьютер, вы откровеннее говорили бы о его просчетах». А в некоторых случаях, по мнению Грэтча, «нечеловеческий вид» роботов может восприниматься людьми как признак беспристрастности и одинакового отношения ко всем.

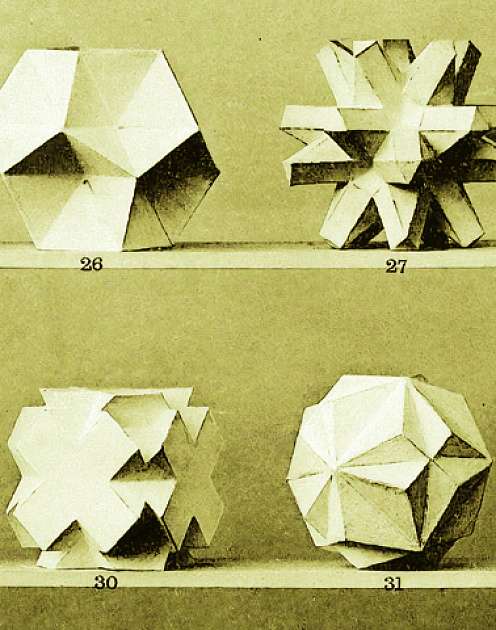

Наше восприятие роботов объясняется тем, как в массовой культуре на протяжении жизни нескольких поколений изображали роботов. Вот несколько самых запоминающихся образов. Они сгруппированы по степени похожести на людей и опасности для них.

Когда люди предпочитают сотрудничать с роботами

Как сложится наше сотрудничество с думающими машинами, будет зависеть от характера работы, от постановки задачи и от дизайна машины. Но при благоприятных условиях люди весьма охотно общаются с коллегами-роботами. Джулия Шах и другие ученые из MIT поставили такой эксперимент: группы, состоявшие из добровольца, ассистента и робота, должны были вместе собирать Lego; всех попросили представить себе, будто они работают на производстве и должны уложиться в жесткие сроки. Чтобы быстро выполнить задание, им надо было правильно распределить между собой обязанности.

Группы собирали по три модели. Сначала задания давал робот: взять детали Lego с одного стола и собирать на другом. Потом начальником был доброволец. В третьем случае доброволец делал свою часть работы сам по себе, а робот распределял оставшуюся между собой и ассистентом. Исследователи предполагали, что добровольцам больше понравится третий вариант, поскольку они смогут работать самостоятельно, а робот будет делать то, на что он запрограммирован. На самом же деле они предпочли первый вариант, при котором задания распределял робот. Он действительно оказался самым удачным: группы работали быстрее, чем во втором и третьем случае.

Почему здесь люди оказались покладистее, чем участники эксперимента в Уортоне, отказавшиеся доверять алгоритму? Мы еще слишком мало знаем, чтобы дать точный ответ. Джулия Шах отмечает тот факт, что время было очень ограничено, потому люди и поняли, что им выгодна помощь робота. И постановка задачи тоже, скорее всего, сыграла роль: надо было работать максимально производительно и уложиться в заданное время — именно такого рода логические задачи лучше всего решают роботы. Наконец, хотя робот не говорил и разработчики не предусмотрели для него возможность «общения», тело у него было и, наверное, он производил впечатление более разумного, чем бестелесные алгоритмы.

В конце эксперимента добровольцы объясняли, почему предпочли тот или иной вариант распределения работы. Показательно, что те, кто поручил это роботу, не говорили о том, насколько он похож на людей, и о том, что с ним завязались некие отношения. Эти люди приводили такие аргументы: «Зато я не потерял ни минуты времени» или «В таком случае планирование работы никак не зависит от тщеславия начальника». Робот оказался отличным сотрудником, так как делал именно то, что лучше всего удается роботам.