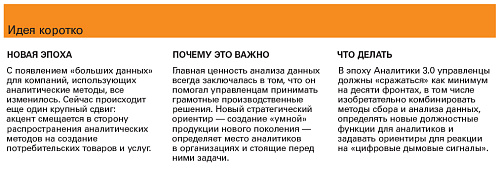

Те из нас, кто годами изучал, как работают информационно «подкованные» компании, считают, что уже закончились две эпохи «больших данных». Их можно назвать ДБД и ПБД — «до больших данных» и «после больших данных». А если воспользоваться вынесенным в заголовок термином, то можно сказать, что место Аналитики 1.0 заняла Аналитика 2.0. В общем и целом, версия 2.0 не просто слегка подправлена или чуть лучше работает, чем предыдущая. Она появилась в результате радикального переосмысления накопленного опыта, благодаря новым приоритетам и техническим возможностям. Изменения были порождены самой жизнью: с какого-то момента компании стали в своей деятельности опираться на анализ «больших данных» — неструктурированной информации, поступающей из многочисленных новых источников.

А теперь, похоже, начинается очередной сдвиг — глубокий и сулящий большие последствия, который без натяжек можно назвать Аналитикой 3.0. Если коротко, то эта новая концепция применения эффективных методов сбора и анализа данных не ограничивается лишь повседневной работой компании, а охватывает ее продукты и услуги.

Далее я разовью эту мысль и докажу, что нынешние инновации лидеров нескольких отраслей свидетельствуют о начале новой эпохи, точно так же, как чуть раньше использование «больших данных» ознаменовало разрыв с прошлым в виде Аналитики 1.0. Когда Аналитика 3.0 начнет пускать корни, то есть когда компании будут уже иначе понимать, в чем их сила, и иначе пользоваться ею, их руководителям придется интеллектуально перестраиваться на нескольких направлениях сразу. Перемены наступают стремительно, причем затронут они весь деловой мир. Появляются новые игроки и технологии, смещаются конкурентные позиции, молодежь выбирает новые интересные специальности.

Все это руководители ощутят в ближайшие годы, а то и месяцы. Лучше всего подготовятся к происходящему те, кто сопоставит факты и поймет, что сейчас переосмысливаются самые основы «информационной» конкуренции. И задавать тон будут те компании, которые первыми увидят общее направление развития, то есть которые уже более или менее представляют себе суть Аналитики 3.0.

Эволюция аналитики

Я не предполагаю подробно излагать историю бизнес-аналитики. Но все же полезно оглянуться назад и вспомнить, в каких условиях произошел последний крупный рывок. Анализ данных, необходимых для принятия решений, — идея, безусловно, не новая. Люди всегда в своих решениях полагались и полагаются на доступную им информацию. Но как область знания бизнес-аналитика сформировалась в середине 1950-х: именно тогда появились инструменты, с помощью которых можно было собирать, обрабатывать и хранить большие объемы информации и выявлять в ней закономерности гораздо быстрее, чем когда-либо раньше было под силу «невооруженному» человеческому уму.

Аналитика 1.0 — эпоха «бизнес-информации». В эпоху Аналитики 1.0 произошел настоящий прорыв в осмыслении бизнеса, его самых важных проявлений. Руководители в своих решениях смогли уже опираться не только на интуицию, но, прежде всего, на факты. Именно тогда, впервые в истории, данные о производственных процессах, продажах, обслуживании клиентов и т.п. стали записывать, накапливать и анализировать.

Главную роль играли новые компьютерные технологии. Сначала информационные системы разрабатывались для собственных нужд компаниями, масштаб которых оправдывал соответствующие затраты; а потом внешние поставщики стали создавать системы общего применения и продавать их широкому кругу пользователей. Это была эпоха корпоративных хранилищ данных, которые позволяли собирать и обрабатывать большие объемы бизнес-информации и ПО для ее анализа.

Потребовались и новые профессиональные навыки, прежде всего — умение работать с информацией. Банки данных были относительно небольшими и статичными, а потому информацию можно было анализировать прямо в корпоративных хранилищах. Но вот выбирать и готовить данные для анализа было непросто. У специалистов на эту работу уходило времени больше, чем на сам анализ.

Важнее всего было правильно сформулировать несколько главных вопросов, поскольку анализ, кропотливый и медленный, занимал недели и даже месяцы. А в отчетах — а это была основная часть всей деятельности, связанной с бизнес-информацией, — говорилось главным образом о том, что уже произошло; они не помогали ни объяснять происходящее, ни делать прогнозы.

Смотрели ли тогда на аналитику как на источник конкурентного преимущества? В широком смысле — да, но никто тогда не думал о «конкуренции в области аналитики». Главным преимуществом была операционная эффективность — способность на основе аналитики принимать максимально обоснованные решения по ключевым вопросам.

Аналитика 2.0 — эпоха «больших данных». Основные условия, способствовавшие Аналитике 1.0, продержались полстолетия — до середины 2000-х, когда фирмы, работа которых основывалась на интернете и социальных сетях (преимущественно фирмы Силиконовой долины — Google, eBay и др.), начали накапливать и анализировать новые виды информации. Хотя термин «большие данные» появился не сразу, новая реальность, которую он обозначает, очень быстро изменила роль данных и аналитики в этих компаниях. Кроме того, стали различать «большие данные» и «малые данные», поскольку первые создавались не только внутренними системами фирм в ходе транзакций — они формировались и за счет внешних источников: интернета, датчиков разных типов, доступных любому интернет-пользователю баз данных международных исследований вроде проекта «Геном человека», аудио- и видеозаписей.

Эпоха Аналитики 2.0 ознаменовала появление новой потребности — в мощных инструментах и новой возможности — зарабатывать на них деньги. В борьбе за клиента компании бросились создавать приложения. Завоевавшая умы идея преимущества первопроходца не только вызвала немалый ажиотаж, но и заставила компании выпускать новинки с невиданной прежде скоростью. Например, в социальной сети LinkedIn появилось множество приложений для анализа информации, в том числе People You May Know, Jobs You May Be Interested In, Groups You May Like, Companies You May Want to Follow, Network Updates, Skills and Expertise. Для этого компания создала сильную инфраструктуру и наняла лучших специалистов. Исключительно удачное приложение Year in Review, которое позволяет следить за изменениями в профилях пользователей своего контактного листа (новые места работы, новые должности или новое дело), было разработано всего за месяц. И не только LinkedIn старается уложиться в самые сжатые сроки. Один гендиректор ИТ-стартапа сказал мне: «Мы попробовали так называемую гибкую методику разработки, но для нас она оказалась слишком медленной».

Приходилось создавать, приобретать и осваивать всевозможные новые технологии. «Большие данные» невозможно было разместить и обработать на одном сервере, поэтому это делали с помощью Hadoop, ПО с открытым кодом для пакетной обработки данных на параллельных серверах. Поскольку компании имели дело с относительно неструктурированной информацией, они стали пользоваться базами данных нового типа — NoSQL. Большие массивы информации хранили в общедоступных или частных облачных базах данных. Появились и другие технологии: например, обработка данных в оперативной памяти и в базе данных — для ускорения «перемалывания чисел». Методы машинного обучения (полуавтоматическое создание и тестирование модели) применялись для того, чтобы быстро создавать модели на основе мощного потока информации. Черно-белые отчеты уступили место цветной и сложной визуализации.

Таким образом, Аналитика 2.0 требовала совсем иных профессиональных знаний, чем Аналитика 1.0. Теперь специалистов по количественному анализу стали называть специалистами по данным; они были не только аналитиками, но и программистами. Скоро этим профессионалам стала тесна их вспомогательная роль: они хотели разрабатывать новую продукцию и влиять на бизнес компании.

Аналитика 3.0 — эпоха данных, генерируемых потребительскими продуктами. В эпоху 2.0 проницательный наблюдатель мог заметить признаки зарождения аналитики нового типа. Ведущие фирмы «больших данных» из Силиконовой долины начали разрабатывать технологии сбора и анализа данных, необходимых для создания новой продукции, а также генерируемых потребительскими товарами, промышленным оборудованием и в ходе предоставления услуг. Их сайты привлекали пользователей более совершенными алгоритмами поиска, рекомендациями друзей и коллег, описаниями продукции и рекламой, нацеленной на конкретного человека, — и все это достигалось благодаря анализу колоссального объема информации.

Аналитика 3.0 знаменует собой поворотный момент: участвовать в аналитической гонке стали все. Сейчас не только интернет-компании и фирмы, занятые в сфере информационных технологий, но предприятия всех остальных отраслей создают товары и услуги на основе анализа данных. Если вы что-нибудь производите, перевозите, потребляете или оказываете услуги, у вас по ходу дела постоянно накапливается информация — о каждом устройстве, каждой отгрузке и каждом клиенте. Теперь можно анализировать эти данные и находить ответы, полезные потребителям и рынкам, и принимать основанные на данных решения, касающиеся бизнеса, в том числе об информационной поддержке оборудования, оптимизации и т.д.

Эта эпоха аналитики, как и первые две, не только открывает перед компаниями, которые хотят побеждать конкурентов на поле аналитики, и перед поставщиками необходимого для этого ПО широкие перспективы, но и сулит новые трудности. Об этом мы поговорим чуть позже. Но сначала посмотрим, как обстоят дела с Аналитикой 3.0 в некоторых крупных компаниях, тех, что большую часть своей долгой истории не имели никакого отношения к информационным технологиям или интернету.

«Новый хит», бета-версия

Немецкой компании Bosch Group 127 лет, но по части применения аналитических методов она из тех, что «впереди планеты всей». Подразделения, которые разрабатывают и внедряют системы сбора и анализа данных, генерируемых промышленным оборудованием, разрабатывают интеллектуальные системы, например решения для мониторинга автопарка, грузоперевозок, городского и муниципального транспорта, в том числе инфраструктуры зарядки для электрических и гибридных автомобилей, энергопотребления, безопасности (анализ видеоданных) и многого другого. Чтобы эта инновационная деятельность быстрее набирала обороты, в Bosch создали Software Innovations Group: в ее ведении — «большие данные», аналитика и то, что теперь называют интернетом вещей.

Французской компании Schneider Electric 170 лет. Раньше она производила железо, сталь и оружие. Сейчас ее основная специализация — электроэнергетика и автоматизированные системы управления, в том числе энергозатратами и«умными электросетями», а также системы безопасности и автоматизации для зданий. Она приобрела целый ряд компаний, разрабатывающих ПО для обработки данных, в Силиконовой долине, Бостоне и во Франции. Ее система управления распределительными сетями, например, предназначена для энергетиков. Она контролирует работу устройств, подключенных к сети, отслеживает перебои в электроснабжении, помогает диспетчерам организовывать работу ремонтных бригад и т.д. Она собирает миллионы показаний самых разных датчиков о состоянии распределительных сетей энергокомпаний и предоставляет их инженерам визуальную аналитику.

Ставку на инновационное использование данных сделала и General Electric, компания, которая существует уже более 120 лет. Производственные подразделения GE все больше превращаются в провайдеров услуг по оптимизации производства и существующих мощностей. В компании считают: чем шире поток данных с датчиков на турбинах, электровозах, реактивных двигателях, томографах и другом оборудовании, тем эффективнее оно будет работать и тем проще оно в эксплуатации. В компании появился термин — «промышленный интернет». Чтобы развивать это направление и обеспечивать себя квалифицированными специалистами, компания вложила более $2 млрд в новый центр — он находится недалеко от Сан-Франциско, — который разрабатывает ПО для промышленной аналитики. Сейчас GE продает свою технологию другим промышленным компаниям — для управления «большими данными» и аналитикой. К тому же она разработала новые технологические коммерческие продукты на основе концепции «больших данных»: например, платформу Predix для создания приложений к «промышленному интернету» (она обеспечивает безопасный способ телематического подключения к оборудованию, сбор и передачу больших объемов данных) и аналитическую систему Predictivity (24 приложения для оптимизации производственных процессов и работы оборудования на платформе Predix для всех отраслей).

UPS 107 лет. Но в том, как эта компания применяет современные аналитические технологии в своих производственных процессах, в данном случае — при разработке оптимальных маршрутов доставки грузов, равных ей еще поискать. Что такое «большие данные», UPS знает не понаслышке; одна из крупнейших компаний мира, специализирующихся на транспортировке грузов, она с 1980-х отслеживает движение посылок. Ежедневно она доставляет в среднем 16,3 млн отправлений и обрабатывает 39,5 млн запросов об их нахождении. Самый новый источник «больших данных» UPS — телематические датчики, установленные на 46 с лишним тысячах ее грузовиков, и системы GPS. Датчики фиксируют скорость, направление движения, состояние тормозной системы и трансмиссии. Поток входящих данных помогает не только правильно оценивать эффективность маршрутов, но и подсказывает, как оптимально изменять их. Система, которая делает это, называется ORION (On-Road Integrated Optimization and Navigation). Это, пожалуй, крупнейший в мире проект научной организации производства. При расчете маршрута система использует онлайновые карты и алгоритмы оптимизации и вскоре сможет управлять маршрутом водителя в режиме реального времени. В 2011 году с ее помощью удалось сократить пробег автопарка UPS в общей сложности на 140 млн километров и сэкономить 32 млн литров горючего.

Руководители всех перечисленных компаний не только смотрят на новые аналитические технологии с точки зрения традиционной конкуренции (как способ повысить качество принимаемых в их компаниях бизнес-решений), но и видят в них инструмент для создания товаров и услуг нового класса.

Наверняка кто-нибудь из читателей скажет, что с наступлением новой эпохи исполняется давнее предсказание. Стэн Дэвис и Билл Дэвидсон еще в 1991 году выпустили книгу «2020 Vision: Transform your Business Today to Succeed in Tomorrow’s Economy», в которой утверждали, что компаниям необходимо «информатизироваться», то есть производить «умную» продукцию со встроенными датчиками и продавать ее по электронным каналам. Авторы отмечали, что «информационные выбросы», которые производят компании, можно собирать и использовать для разработки инновационных решений. Тогда эти идеи привлекли внимание только тех компаний, которые уже работали поставщиками информации, например Quotron (данные о фондовом рынке) и Official Airline Guide (данные о рейсах различных авиакомпаний). А сейчас и банки, и производственные предприятия, и медицинские учреждения, и розничные сети — все компании, независимо от отрасли, которые хотят идти в ногу со временем, — могут собирать и анализировать информацию и на ее основе разрабатывать нужные потребителям товары и услуги.

Когда Дэвис и Дэвидсон писали свою книгу, достаточно было лишь предоставлять информацию. Но сейчас мы завалены ею, и времени, чтобы превращать ее в идеи, уже ни у кого нет. Прежние поставщики информации должны стать поставщиками идей; они должны препарировать информацию и говорить нам, что с ней делать. Первыми это поняли онлайн-бизнесы, которые располагают огромным объемом сведений о поведении пользователей интернета. Google, LinkedIn, Facebook*, Amazon и др. добились успеха не потому, что предоставляли информацию, а потому что указывали самый короткий путь к решению и действию. Компании, предоставляющие обычные информационные услуги, сейчас тоже идут по их следам.

Как заработать на Аналитике 3.0

Это стратегическое смещение фокуса внимания означает, что аналитика в организациях будет играть другую роль. Компаниям придется признать необходимость целого ряда связанных с этим преобразований, осваивать новые навыки, создавать новые должности и намечать новые приоритеты.

Множество данных разного типа. Организациям надо будет объединять большие и малые объемы данных, которые поступают из внутренних и внешних источников в структурированном и неструктурированном форматах, и из этой мешанины информации извлекать новые идеи, воплощенные в прогнозирующих и «предписывающих» моделях (последние обращены к непосредственным исполнителям). Скажем, данные, которые поступают с новых датчиков, установленных на грузовиках транспортной компании Schneider National, включаются в алгоритмы оптимизации логистики, что позволяет контролировать ключевые показатели: уровень топлива, объем и местонахождение контейнера, действия водителя. Компания постоянно совершенствует свои маршруты, добиваясь их максимальной эффективности, сокращения расходов горючего и уменьшения вероятности ДТП.

Новые средства управления данными. В эпоху Аналитики 1.0 компании получали справочную, аналитическую и обобщающую информацию из хранилищ данных. В эпоху 2.0 бизнес переключился на кластеры Hadoop и базы данных NoSQL. Сейчас технологический «рецепт» таков: все вышеперечисленное. Хранилища данных, оборудование для облачных вычислений, вычислительная среда, в которой традиционные запросы к базе данных сочетаются с Hadoop (иногда это называют Hadoop 2.0), вертикальные и графические базы данных и многое другое. Количество и сложность решений, которые разработчикам ИТ-архитектуры приходится принимать в связи с управлением информацией, существенно возросли, и практически все организации придут в итоге к гибридной среде данных. Старые форматы никуда не делись, но нужны новые процессы, чтобы данные и анализ перетекали из одного приложения в другие. Более быстрые технологии и методы анализа. Технологии обработки «больших данных» периода Аналитики 2.0 работают с информацией значительно быстрее, чем инструменты предыдущих поколений. Кроме того, сейчас применяются новые методы анализа и методики машинного обучения — они помогают быстрее находить точные решения.

Эти методы, подобно методам гибкой разработки систем, предполагают, что участники проекта получают частичную информацию с пылу с жару; как и лучшие специалисты по данным, они постоянно работают в условиях цейтнота. Задача Аналитики 3.0 — так адаптировать процессы производственной деятельности, разработки новых продуктов и принятия решений, чтобы можно было в полной мере пользоваться преимуществами новых технологий и методов.

Встроенная аналитика. В эпоху Аналитики 3.0, когда скорость обработки данных и анализа резко возрастает, модели обычно становятся неотъемлемой частью повседневной работы и принятия решений, и это придает всем процессам немыслимое прежде ускорение и повышает их результативность. У Procter & Gamble аналитика, например, таким образом «участвует» в процессе принятия повседневных управленческих решений: в 50 с лишним офисах компании специально оборудовали залы для совещаний, в которых на большие экраны при обсуждении того или иного бизнес-вопроса проецируется визуализированная информация, а более чем 50 тысяч сотрудников получают ее прямо на свои компьютеры. Одни компании «встраивают» аналитику в автоматизированные системы посредством алгоритмов скоринга и основанных на аналитике и заложенных в системах правилах, другие — в предназначенную для потребителей продукцию и ПО.

Как бы то ни было, благодаря «присутствию» аналитики в системах и процессах, во-первых, повышается скорость принятия решений и работы вообще, а, во-вторых, руководители уже не могут не пользоваться аналитикой, что, как правило, хорошо.

Открытия. Чтобы разрабатывать продукты и услуги на основе данных, компаниям нужны системы типа Data Discovery (в огромных массивах структурированных и неструктурированных данных они выявляют скрытые закономерности и предлагают нетривиальные, практически полезные интерпретации, необходимые для принятия решений). Нужны им также профессионалы, умеющие работать с такими системами, и соответствующие процессы. Хотя изначально корпоративные хранилища данных предназначались для того, чтобы упрощать поиск информации и ее анализ, во многих организаций они стали своего рода депозитариями производственной информации, и, как уже отмечалось, сбор и загрузка данных в эти системы отнимает массу времени. Среда Data Discovery позволяет быстро определять основные свойства набора данных без особой его подготовки.

Междисциплинарные группы анализа данных. В интернет-компаниях и стартапах, работающих с «большими данными», специалисты по данным заправляют всем. Но в крупных и более традиционных компаниях им необходимо сотрудничать с другими профессионалами, чтобы аналитические инструменты соответствовали масштабу данных. В большинстве случаев эти специалисты занимаются просто количественным анализом, на поддержку массивов данных они вынуждены тратить больше времени, чем им того хотелось бы (отнюдь не новое явление). Сейчас в компаниях специалисты по извлечению и структурированию информации работают бок о бок с аналитиками, которые превосходно ее моделируют. И те, и другие должны сотрудничать с «айтишниками», которые поставляют «большие данные», обеспечивают аналитическую инфраструктуру и «песочницы», в которых специалисты «играют» со своими данными. Такая сборная команда трудится в поте лица, и не всегда понятно, кто за что отвечает.

Главный аналитик. Если аналитики так важны, значит, кто-то в руководстве компании должен отвечать за их работу. Поэтому кое-где для надзора за созданием и использованием аналитических мощностей уже появляются директора по аналитике. Эти посты существуют в таких компаниях, как AIG, FICO, USAA, Медицинский центр университета Питтсбурга, в Wells Fargo и Bank of America. Список, безусловно, будет расширяться.

«Предписывающая» аналитика. Аналитика бывает трех типов: описательная (ее «предмет» прошлое), прогностическая (предсказывает будущее с помощью моделей, использующих информацию о прошлом) и «предписывающая» (выявляет оптимальную тактику). В эпоху Аналитики 3.0 сосуществуют все три типа — с упором на третьем. «Предписывающие» модели подразумевают и масштабное тестирование, и оптимизацию, и встраивание аналитики в ключевые производственные процессы, и повседневную деятельность специалистов. Они поднимают работу компании и каждого ее сотрудника на качественно новый уровень, но требуют взамен точного планирования и профессионального исполнения. Если, скажем, система ORION компании UPS давала бы водителям неточную информацию о маршрутах, от нее давно бы уже отказались. По словам руководителей UPS, на переделки и перенастройки они потратили гораздо больше времени, чем на разработку алгоритмов и систем.

Аналитика в промышленном масштабе. Компаниям, которые пользуются аналитическими инструментами в основном для совершенствования своих процессов принятия решений, Аналитика 3.0 позволяет переходить на совершенно новый уровень. Создавая за счет машинного обучения в разы больше моделей, организация может составлять гораздо более подробные и точные инструкции и прогнозы. Скажем, раньше IBM, генерируя спрос на свою продукцию (в частности, оценивая, как распределить усилия отдела продаж между клиентами), полагалась на 150 аналитических моделей. Благодаря партнерству с небольшой компанией Modern Analytics, с которой IBM работает по принципу «фабрики ПО» и «конвейера данных», в ее распоряжении теперь 5 тысяч моделей. Отвечают за все это четыре сотрудника: 95% моделей создаются без участия человека, а еще 3% требуют от аналитиков лишь минимальной настройки. Новые модели применяются для анализа конкретных продуктов, потребительских сегментов и регионов. Как показало тестирование, проведенное на крупном азиатском рынке, эти модели, по сравнению с нестатистическими методами сегментирования, способствовали удвоению коэффициента обработки запросов пользователей.

Новые способы принятия решений и управления. Чтобы ваша компания преуспевала в эпоху Аналитики 3.0, вам нужны новые принципы принятия решений. Следуя им, вы будете яснее, чем прежде, представлять себе конечные результаты тех или иных шагов. Руководителям следует признать, что без аналитики и экспериментов теперь никуда, а потому они должны требовать, чтобы любая важная инициатива предварялась небольшими, но последовательными и жестко контролируемыми экспериментами, которые позволяли бы выявлять причинно-следственные связи. Представьте себе, например, как было бы хорошо, если бы Рон Джонсон во время пребывания на посту главы J.C. Penny, прежде чем рубить с плеча, сначала проверял бы свои идеи в ограниченном масштабе (Джонсон для привлечения покупателей кроме всего прочего запретил скидки; из-за его нововведений компания за два года потеряла $4 млрд). Как ни парадоксально, несмотря на широкую доступность «больших данных» определенности они не слишком-то прибавляют. «Большие данные» — это бурный поток. Представьте себе, что вы анализируете, что говорят о вашем бренде в социальных сетях: показатели отношения потребителей неизбежно будут то подскакивать, то падать. Такого рода «цифровые дымовые сигналы», как их называют, могут свидетельствовать о назревающих проблемах, но они лишь подтверждают наличие тенденций, но не подтверждают их устойчивость. Руководители должны проинструктировать подчиненных о том, в каких случаях нужно обращать внимание на эти ранние сигналы и принимать соответствующие меры. Добавляет неопределенности и характер зависимостей в среде «больших данных».

Анализ, если только они не обнаружены путем формального тестирования, обычно выявляет не причинные связи, а корреляционные, и иногда они возникают случайно (хотя, чем больше объем информации, тем выше вероятность, что слабые результаты окажутся статистически значимыми). Некоторых руководителей все это может сбивать с толку. Если речь идет о чем-то важном, нужно продолжать исследование и только потом принимать решение. Компаниям, которые преуспевают на ниве «предписывающей» аналитики, приходится по-новому управлять персоналом. Снабдив датчиками водителей грузовиков, летчиков, работников складов (собственно, при наличии датчиков на смартфонах в этот перечень можно включить всех без исключения сотрудников), компании смогут следить за работой каждого отдельного человека. Сотрудники, конечно, будут не в восторге от такого контроля. Аналитика аналитикой, возможности возможностями, но иногда надо думать и о людях.

Создание стоимости в информационной экономике

Станет ли Аналитика 3.0 высшей точкой эволюции информационной экономики? Скорее всего, нет. Но, не боясь ошибиться, можно сказать, что эту эпоху будут вспоминать как время, когда бизнес принял новые правила игры.

Интернет-компании, которые завалили мир «большими данными», были завязаны на них с самого начала. Им не надо согласовывать или объединять «большие данные» с информацией из традиционных источников и проводить ее анализ: по большей части они традиционными источниками не пользуются. Им не нужно встраивать технологии «больших данных» в обычную ИТ-инфраструктуру — у них такой инфраструктуры просто нет. Они могут препарировать только «большие данные», или анализ «больших данных» может быть единственным видом проводимого ими анализа, а кроме технологий «больших данных» других ИТ-технологий им может и не требоваться. Но сейчас каждая из этих компаний возделывает собственную версию Аналитики 3.0.

Ясно одно: новые технологии и профессиональные навыки, необходимые и старожилам рынка, и новичкам, не освоить, пользуясь старыми моделями бизнес-аналитики. Модель «больших данных» была гигантским шагом вперед, но и она однажды устареет. Компании, если они хотят процветать в новой информационной экономике, должны провести большую интеллектуальную работу и понять, как благодаря анализу данных они могли бы развиваться сами и создавать то, что необходимо потребителям. Аналитика 3.0 — ориентир в эпоху перемен и новая модель конкуренции.